我们将和大家一起来了解一下,本次英伟达在2024GTC发布的全新Blackwell AI芯片,到底牛在哪里,又有什么无法逾越的护城河呢?

算力的五个层次

在具体分析Blackwell之前,我们可以先从黄仁勋的分析师电话会议中,对GB200的设计理念做一个大致的了解。

GB200是英伟达推出的最强大的AI超级芯片,他们也可能组成这个地球上,迄今为止算力最强的AI服务器。英伟达是如何实现这一点的呢?

答案很简单,就是靠暴力堆——开个玩笑,当然是他不惜重金研发的独门科技,和思路清晰的扩张方案。为了做到这一点,黄仁勋给出的答案是:将算力设计分成五个物理层次,并且在每一个层次都做到当前技术所允许的最好。黄仁勋说,Blackwell系列芯片的研发成本大概为100亿美金,这应该不是玩笑。

今天,我们就来对这5层算力做出层层解析。

第一层算力:单芯片算力

在同等工艺制程约束下,芯片的面积越大,晶体管的数量就越多。为了做出地球上最大的芯片,英伟达的Blackwell芯片尺是一整块wafer(晶圆)在光刻机曝光极限下所能支持的最大面积:800mm^2。按照CEO的原话说:如果我们做的再大一点,那么整块晶圆估计都会因为物理极限而断裂。

在很多人眼里,AI算力的本质就是流处理多核运算单元(Streaming Multiprocessor,SM,下同)的堆积。从某种意义上说,单一显卡的算力确实是可以这么计算,通过增加SM提升算力,这也是为什么华为的晟腾处理器910B号称在某些程度上已经接近A100的水平了。

虽然接下来我们将会看到,单显卡算力只是AI算力的第一级层次,但这并不妨碍我们探寻一下2024年全新发布的Blackwell,在单卡算力方面究竟取得了什么进展?

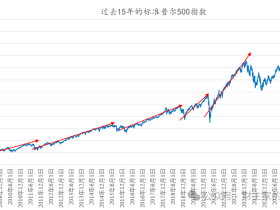

为了回答这个问题,我们先回顾一下历代英伟达AI加速卡的算力发展史:

英伟达的第一代AI加速卡叫Volta ,是英伟达第一次为AI运算专门设计的张量运算(Tensor Core)架构。该架构GPU V100 包含80个SM单元,每个单元内有4个双核Block共计8个计算核心(下同),每个核心一个周期可以完成128个16位浮点数乘法累加。V100的运行频率是1.53GHz,稍微计算一下可知,V100的浮点计算算力为80*8*128*1.53GHz = 125 Tera FLOPS,简写成125 TFLOPS。

Volta 架构

为方便大家理解,这里对名词缩写稍微进行一些解释:FLOPS是 FLoating point Operations Per Second的缩写,也即每秒浮点运算数。Tera是一种科学计数法的单位,1 Tera 等于 1000 Giga。这里的Tera和我们硬盘中的1TB中的T代表的是一个数量级。

英伟达的第二代张量计算架构叫图灵(Turing),代表显卡T4。一张T4显卡中只有40个SM,其他数据和V100基本接近,因此T4的算力基本只有V100的一半,也即65 TFLOPS。

至于为什么图灵架构的单卡Tensor算力不升反降,可能因为他其实是为游戏卡而生所致。

第三代张量运算架构安培(Ampere),终于来到我们比较熟悉的A100系列显卡了。在芯片工艺升级的加持下,单卡SM翻倍到了108个,SM内的核心数和V100相同,但是通过计算单元电路升级,核心每一个周期可以完成256个浮点数乘累加,是老架构的两倍。主频稍微下降,并且加入了更符合当时深度学习需要的8位浮点(FP8)运算模式,一个16位浮点核心可以当作2个8位浮点核心计算,算力再翻倍。主频稍有下降,为1.41GHz。因此最后,A100显卡的算力达到了V100的近5倍,为108*8*256*1.41GHz*2 =624 TFLOPS (FP8)。

Ampere 架构

第四代架构Hopper,也就是英伟达去年刚发布、OpenAI大语言模型训练已经采用、且因算力问题被禁运的H100系列显卡。该显卡的SM数(132个)相较前代并未大幅提升,但是因为全新的Tensor Core架构和异步内存设计,单个SM核心一个周期可以完成的FP16乘累加数再翻一倍,达到512次。主频稍微提高到1.83GHz,最终单卡算力达成惊人的1978 Tera FLOPS(FP8),也即首次来到了PFLOPS(1.97 Peta FLOPS)领域。同样地,1 PFLOPS = 1000 TFLOPS。大家家里的硬盘如果再扩容一千倍,就有1PB了。这一般是大型数据中心的储存单位。

Hopper 架构

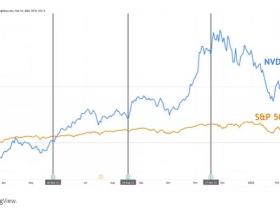

老黄上周发布的第五代架构Blackwell,在这个算力天梯上又取得了什么样的进展呢?根据公开的数据,如果采用全新的FP4数据单元,GB200在将能在推理任务中达到20 Peta FLOPS算力。将其还原回FP8,应该也有惊人的10 PFLOPS,这相对H100提升将达到5倍左右。

公开数据显示,Blackwell的处理器主频为2.1GHz。假设架构没有大幅更新,这意味着Blackwell将有600个SM,是H100的接近4倍。Blackwell有两个Die,那么单Die显卡的SM数也达到了H100的2倍。

由此可见,晶圆面积和芯片大小,对Blackwell的算力至少做出了一半的贡献。这种提升是光刻工艺、芯片蚀刻、晶圆物理限制方面的提升,也就是我们所说的,第一个层次的提升。

当然,这些年英伟达在Tensor Core架构设计上的不断精进,包括为Transformer优化过的流水线和专属CUDA驱动,也为算力的提升做出了重要贡献:

这里,我们将从Volta架构至今的算力天梯进展图列表如下,方便大家查阅:

由上表可知,Blackwell算力提升,主要来自于SM数的增加。总算力相较2023年推出的Hopper,提升约为5倍。相比2017年推出的Volta架构,提升约为40倍。

第二层算力:Die-to-Die相通,一片双芯

Blackwell能够做到600个SM的根本原因,在于他做出了世界上最大的Chiplet:把两个GPU核心直接“粘”起来,变成一个大小突破单一晶圆物理限制,通信速度达到10TB/s以至于两个核心会认为自己是一块芯片的巨无霸。

注意:对于今天的特别内容,只需输入您的邮箱,免费订阅即可阅读全文。全文约5800字

一块芯片,受到掩膜、曝光、晶圆和工艺尺寸等限制,最大也就只能塞进一定数目的晶体管:这就是当今半导体工业的极限。而英伟达的Blackwell GPU已经进入了这个极限:它的芯片面积为800平方毫米,被称作Reticle-Sized,也就是光刻机受掩膜大小限制,能够生产单个芯片的的极限尺寸。

注意到,一块Blackwell芯片是由左右两个Die拼接而成

然而老黄却显然不满足于这样的限制。他不可避免地进入了算力层次的下一阶段:双die互联,把他们组成一个更大的chiplet。只要互联的速度足够快,那么这两块芯片就会认为自己是一块芯片:世界上最大的GPU就由此诞生了。

为什么是两块互联,而不是三块、四块?“一生二,二生万物”;“两块”是芯片通信互联的起点,同时也是当前技术下,在限制电路复杂度等外部条件后,单个基底上能够实现的最好的解决方案。

苹果也有自己的双Die互联技术,叫做UltraFusion,不过他的通信能力大打折扣,仅仅为2.5TB/s。当然,这对于一款消费级电子产品来说已经够用了。老黄的显卡是工业产品,不能相提并论。

这其实也是英伟达在当今爆炸性增长的算力需求下,一种不计成本的炫技。据透露,Blackwell里高达10TB/s全球最快Die-to-Die通信,采用的是一种叫做NV-HBI(High Bandwitdth Interface)的技术。这项技术尚未公开,我们认为它实际上可能是NVLINK 5.0或者224G XSR serdes的变种:大概用了48组通道,总计带宽为10TB/s。

但不论NVidia最终采用的是哪种技术,这对先进封装(Advanded Packaging)来说都提出了全新的要求。只能说利好封装厂们未来营收再创新高。

封装厂们通过在板内增加贯穿的铜线,再在PCB版背面添加金属焊球导通不同位置的连线,再实现了复杂结构的2.5D互联——这真的是一项技术活。封装,恐怕也是国产芯片产业需要突破的,仅次于光刻机的第二大障碍。

台积电的CoWoS或者InFO可能为英伟达Die-to-Die提供了封装技术,他们也是HBM内存的封装方案。灰色小球就是金属焊球。

最终结果:Blackwell拥有2060亿个晶体管;因为由两个die组成,所以支持高达8条(而不是4条)HBM3e 显存:每条HBM3e容量为24GB,1TB/s带宽。因此,B200显卡将拥有总计高达192GB的显存和8TB/s的显存带宽。

Blackwell显卡的研发成本高达100亿美元。在单显卡算力上做到极致,这是NVDA AI超算处理器的第一道护城河。

至于3、4甚至更多块GPU的互联,老黄的方案是交给算力的下一层次:NVLink来解决。

第三层算力:NVLink,72卡互联

两个die合成一个GPU看似强劲,但在实际运用中却依然不够用。因为对于动辄几百亿参数的大语言模型来说,要想在合理时间内完成对上万亿token海量文本的训练,我们必须要用到大规模并行计算。

数据并行是一方面,模型本身的权重、甚至模型的每一层都需要分配到不同的显卡中实现并行计算,从而做到3个维度的分治加速。关于大语言模型的并行训练,我们可以参考关于HuggingFace中关于的简介。

我们所需要知道的是:哪怕显存再大,对于大语言模型训练来说,一个GPU也远远不够。

对此,英伟达给出的解决方案是:首先将2个Blackwell GPU和一个Arm处理器(也即Grace CPU)装在一个主板上。这款产品,叫做GB200(Grace Blackwell 200)。可想而知,该产品拥有2个Blackwell GPU,4个die,最终FP8算力为 20 PFLOPS,是单个GPU的2倍。两个GPU之间通过NVLink技术在Grace CPU的辅助下实现互联,每个GPU和Grace的通信带宽为1.8TB/s,总带宽为3.6TB/s。具体连接如下图所示:

这还不够。

随后,英伟达将36块这样的PCB板(又叫一个Rack)组装在一个标准服务器机架上。36个主板之间依然利用NVLINK,通过铜缆电信号实现互联。

在NVLink5 标准下,每个显卡最多能和18个GPU同时通信,总带宽为1.8TB/s:这是PCIe 5标准的的14倍。一共72个GPU,他们将拥有1.8TB/s * 72 = 130TB/s的总通信带宽。

这甚至能装下整个互联网。

这样一个搭载72个Blackwell GPU核心的机柜,叫做GB200 NVL72。

72个显卡互联,他比传统的8卡并联方案(比如华为晟腾和AMD)提高了9倍。NVL72可配置的高速HBM3e内存总也从单卡的192GB提高到了13.5TB,内存总带宽最大为576TB/s。

这些数字看起来已经让人头晕了。但我们只需知道,它们对于大模型训练速度的提升是不言而喻的。

和仅仅搭载两个显卡的GB200相比,NVL 72性能提升就是72/2=36倍;我们已经进入了超算世界,一切都是极致的简单,又如此粗暴。

具体地说,GB200 NVL72 FP8算力达到720PFLOPS,FP4更是首次进入Exa(中文音译为艾)领域,达到了1.44Exa FLOPS。这也是为什么在推理任务上,NVL72相比H100,提升可以高达30倍。

Exa级别的算力,基本上已经接近当今世界顶级超算的计算水平。当然,超算的算力是用FP64计算的,但超算们一般都用百万CPU核心才能实现这样的算力,GB200 NVL72仅仅使用了72个。

第四层算力:NVSwitch,SuperPOD

一个机柜不够,那就拿更多机柜来凑。这是朴素的、暴力的、算术的第一性原理。这也是黄仁勋Scale Up超算的基本原理。

从理论上说,借助NVSwitch,NVLink连接GPU的数目上限为576个。这也就恰好等于8台GB200-NVL72机柜。这样的配置,英伟达称之为GB200 SuperPOD。

一台NVSwitch提供的NVLink接口高达144个。这样在一个机柜内,将需要用到9个NVSwitch。9 * 144 恰好等于72个GPU,每个GPU满载18个NVLink 连接所需要的全连接数(72 * 18 = 9 * 144)。NVLink提供的GPU连接是All-to-All的,也即每一个GPU都分别有上行和下行通道,连接到系统内任意另外一个GPU上。

这也是NVLink 5 相比上一代GH100产品最大的优势:在上一代产品中,每个NVSwitch 最多能只能连64个NVLink通道,而NVLINK系统最多能只支持256个GPU全连接。因此GH100的单机柜最大只有32个H100,而不是GB200的6=72个。同样是8个机柜满载256个GPU,总共需要 9*8 = 72台NVSwitch。

机柜与机柜之间,应该是使用英伟达的ConnectX系列网卡,采用InfiniBand标准通过以太网以400GB/s速率连接。这也是为什么我们能在上图背面能看到蓝色网线。800G OSFP一般支持2通道400GB/s或者8通道100GB/s互联。

一个典型的机柜组网方法,以GH100为例

当然也有一种可能,就是最外层的机柜互联依然使用NVSWitch完成,如下图。不过这种组网方法比较异形,是先将8个H100组成一个节点,一共32个节点。每个节点内4使用个NVSwitch完成互联;仿照上图光纤Swtich的排列,最外层再用18个NVSWitch将每一个节点内空余的接口连满。一共需要146个NVSWitch。

一个两层NVSwtich的机柜组网方法,还是以GH100为例

NVSwitch的最大综合带宽为1PB/s,是单个NVLink的近500倍。但最大峰值非阻塞带宽为14.4TB/s,远低于单个NVL72机柜内部的 130TB/s。因此性能的扩展并不是无损的。在训练时,大量的通信任务应该集中在机柜内部,只有在不得已的时候,才需要在机柜之间进行通信:比如训练完一个Batch后,模型梯度的更新。

毫无疑问,如果你能买得起这样8台机柜的话,你所拥有的算力(FP4计算),将达到惊掉下巴的1.44*8 = 11.52 Exa FLOPS。即便是训练常用的FP8,也有5.76 Exa FLOPS。

这让单卡性能刚触及A100,最多只有8个GPU互联训练,通信带宽尚不及400GB/s的晟腾910B,怎么比呢?

第五层算力:AI超级工厂

接下来就是神的领域了。黄仁勋在之前23年的GTC大会上放出了这么一张图,最大支持8000个GPU,20小时完成原本三个月的4千亿参数的MoE混合专家大语言模型训练。英伟达应该正在和Azure等云厂商合作,全球估计也仅此一台。如果有GB200的新图,欢迎大家在留言区告诉我。

这么多GPU,应该是多个SuperPOD之间通过光交换机、光纤拓扑互联完成。整个数据中心都会成为GPU的天下,未来,核电站旁边将耸立着一座又一座算力工厂,正如西部世界 中预言的Rehoboam那样。他们将创造出AGI,主宰人类世界。

至于算力?如果你真的还感兴趣知道的话,这个系统按8000个GPU数量为SuperPOD20倍估算,FP4算力将达到前无古人的220 Exa FLOPS。即便是训练常用的FP8,也将有115 Exa FLOPS。

小结

英伟达仅仅是一家显卡公司?

他其实一家专攻加速浮点矩阵乘累加的数学公司,是一家突破单晶圆尺寸和铜线通信带宽界限的物理公司,是一家重新发明摩尔定律,将从1推广到2,2推广到72,72推广到576,576再推广到8000挑战人类极限的无限Scaling Law公司。

NVidia的技术护城河仅限于显卡吗?

他的核心科技,囊括了die-to-die link,Grace CPU,NVLink,NVSwitch;他掌握了从wafer,到pcb,到机柜,到跨机柜的全尺度互联技术。

英伟达是一个实实在在的高性能计算海陆空综合体,一己之力打通技术上下游的庞然大物。

加上NIM,他就是未来的算力工厂

至于发布GB200之后,NVDA到底应该值多少钱,相信看完本文大家心里也应该有数了。

文:美股投资日报,作者:Bo Zeng

评论